خطاهای کشنده در robots.txt که سئو را میسوزاند

فایلهای robots.txt فایلهای متنی سادهای هستند که در ریشه سایت شما قرار میگیرند. برای بررسی اینکه آیا سایتتان چنین فایلی دارد یا نه، کافیست به آدرس دامنهتان بروید و در انتهای آن /robots.txt را اضافه کنید. مثلا مانند ادرس زیر :

Inadramseo.com/robots.txt

بسیاری از سیستمهای مدیریت محتوا (CMS) مانند وردپرس بهطور خودکار این فایل را ایجاد میکنند، اما این به این معنا نیست که فایل بهدرستی پیکربندی شده است.

فایل robots.txt به خزندههای موتور جستجو (نه فقط گوگل، بلکه تمام موتورهای جستجو) اعلام میکند که به کدام صفحات یا فایلها میتوانند یا نمیتوانند دسترسی داشته باشند. این فایلها برای جلوگیری از ورود رباتها به بخشهایی از سایت که اطلاعات مفیدی در آنها وجود ندارد – مثل پوشه مدیریت وردپرس (wp-admin) – بسیار مفید هستند.

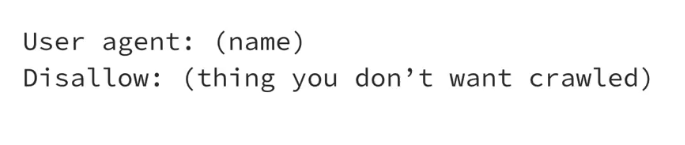

ساختار پایهای فایل robots.txt به این شکل است:

- شما ابتدا عامل کاربر (User-agent) را مشخص میکنید و سپس با دستور disallow صفحاتی را که نمیخواهید خزیده شوند، تعیین میکنید. در واقع تنها همین دو خط برای تشکیل یک فایل robots.txt ساده کافی است: مشخص کردن خزندهای که میخواهید برایش قانون تعیین کنید، و اینکه به آن بگویید چه کاری انجام بدهد یا ندهد.

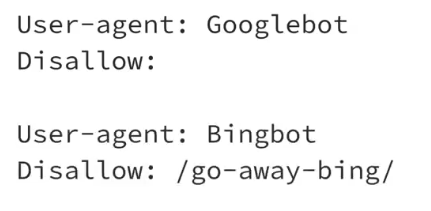

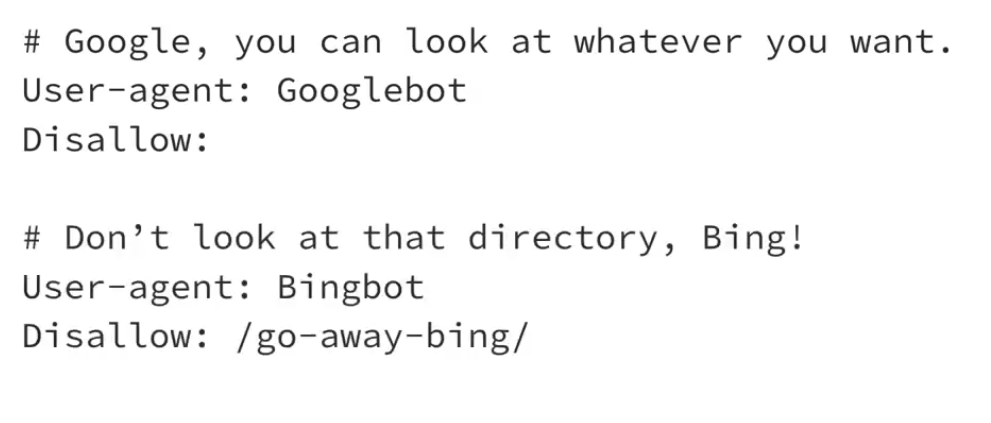

شما میتوانید چندین مجموعه مختلف از User-agentها را هم وارد کنید. مثلاً فرض کنید میخواهید گوگل به همه چیز دسترسی داشته باشد ولی بینگ به پوشهای خاص دسترسی نداشته باشد. در این حالت میتوانید برای گوگلبات دستور disallow خالی بگذارید (یعنی دسترسی کامل)، و برای Bingbot بنویسید که به پوشهای به نام “go-away-bing” دسترسی نداشته باشد.

نکته مهم دیگر این است که مسیرها را به صورت نسبی بنویسید، نه با آدرس کامل (full URL). مثلاً بنویسید

/admin/

نه بصورت https://example.com/admin/.

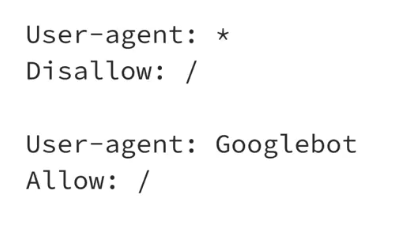

گاهی فایلهای robots.txt به گونهای تنظیم میشوند که فقط به Googlebot اجازهی دسترسی به سایت را میدهند و سایر خزندهها را منع میکنند. اما باید بدانید برخی خزندهها این قوانین را نادیده میگیرند و بدون توجه به آنها، صفحات را میخزند.

همچنین دستور allow فقط برای برخی خزندهها مثل Googlebot و Bingbot معتبر است و سایر خزندهها ممکن است آن را نادیده بگیرند و فقط به دستور disallow توجه کنند.

من توصیه میکنم که همه سایتها حتماً یک فایل robots.txt داشته باشند. چون این فایل باید برای موتورهای جستوجو قابل دسترسی باشد، بنابراین هر کسی هم میتواند آن را ببیند. پیشنهاد میکنم فایل robots.txt سایتهای دیگر را هم ببینید تا با شیوه تنظیمات آنها آشنا شوید.

اگر فایل robots.txt شما خیلی طولانی باشد و دستورات زیادی در آن نوشته شده باشد، باید مراقب تضاد بین قوانین باشید، چون ممکن است در اثر تضاد، نتیجهای که میخواهید حاصل نشود.

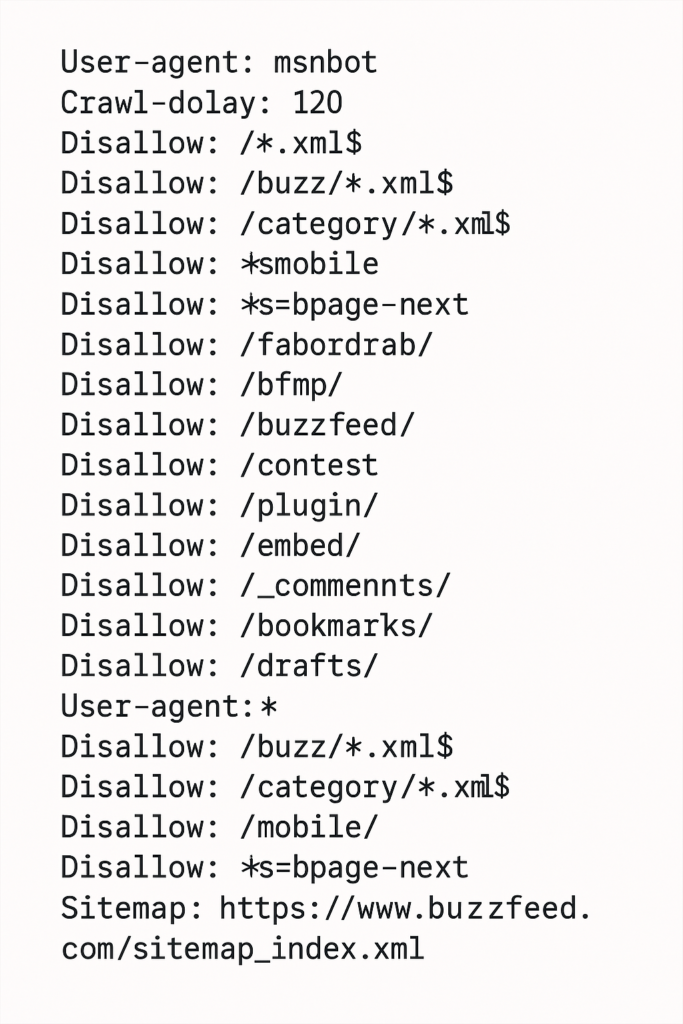

بطور مثال من فابل ربات یک سایت به نام بازفیت را اینجا برای شما میگذارم که نکات جالبی در آن است مثلا :

مثلا گزینه Crawl-delay: 120 که در سطر دوم این دستور هست به موتورهای جستجو میگوید که برای خزش از یک صفحه به صفحه دیگر 120 ثانیه صبر کنند که البته موتور جستجو گوگل آنرا اغلب نادیده میگیرد ولی موتورهای جستجوی دیگر مانند بینگ آنرا انجام میدهد .

در این فایل همچنین از کاراکترهای * (ستاره) و $ (دلار) استفاده شده. علامت * به عنوان wildcard عمل میکند و به شما اجازه میدهد چندین URL را بهصورت همزمان پوشش دهید.

Disallow: /mobile/

Disallow: *?s=mobile

مثلاً در فایل Buzzfeed گفته شده که خزنده نباید چیزی که با s=mobile تمام میشود را بررسی کند.

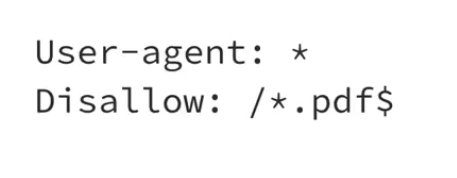

علامت $ نشاندهنده انتهای یک URL است. مثلاً اگر بخواهید تمام فایلهای PDF ایندکس نشوند، مینویسید:

یعنی هر چیزی که به .pdf ختم شود، نباید خزیده شود.

همچنین میتوانید در فایل robots.txt با علامت # توضیحات (کامنت) اضافه کنید تا خواندن فایل آسانتر شود.

Sitemap: https://Inadramseo.com/sitemap_index.xml

یک نکته مهم دیگر این است که لینک به فایل سایتمپ (sitemap) را هم در ابتدای یا انتهای فایل robots.txt خود اضافه کنید. من خودم معمولاً این کار را در انتهای فایل انجام میدهم، ولی انتخاب با شماست. گوگل احتمالاً سایتمپ شما را از طریق

Search Console دریافت میکند، ولی سایر خزندهها از این لینک استفاده خواهند کرد.

چند نکته نهایی برای قالببندی صحیح:

- حتماً نام فایل را به صورت کوچک بنویسید:

robots.txt. استفاده از حروف بزرگ ممکن است باعث شود فایل خوانده نشود. - بعضی خزندهها ممکن است دستورات شما را کاملاً نادیده بگیرند، مخصوصاً آنهایی که برای اسکرپ کردن محتوا طراحی شدهاند.

- همیشه به خاطر داشته باشید که robots.txt یک «پیشنهاد» است، نه یک قانون الزامی.

وقتی فایل خود را ساختید، حتماً با ابزار تست robots.txt گوگل آن را آزمایش کنید تا مطمئن شوید خطایی در آن وجود ندارد. من مواردی را دیدهام که یک فایل robots.txt اشتباه، کل سایت را از نتایج جستوجو حذف کرده است. این فایل کوچک، قدرت بسیار زیادی دارد؛ پس زمان کافی برای نوشتن درست آن صرف کنید.